LLMOps入门(一):概念解析与框架概览

引言

近年来,大型语言模型(LLM)无疑是人工智能领域最炙手可热的明星。从辅助写作、代码生成到智能问答,LLM 的强大能力正深刻改变着各行各业。然而,将这些强大的模型真正应用到实际生产环境中,并确保其高效、稳定、可持续地运行,却并非易事。开发者们常常面临项目复杂度攀升、缺乏标准化流程、模型效果难以追踪评估、迭代缓慢以及成本控制困难等一系列挑战。正是在这样的背景下,LLMOps 的理念应运而生,旨在为大模型应用的生命周期管理提供一套系统性的解决方案。

为了系统性地探讨这一重要领域, 欢迎来到我们的 LLMOps 入门系列!本篇文章是这个系列的第一篇。在整个系列中,我们的目标是带领大家从 LLMOps 的基本概念出发,逐步深入到如何利用专业的工具对 LLM 应用的关键环节——如提示词工程、Agent 的工具调用以及检索增强生成(RAG)系统——进行观测、分析与优化。

在今天的开篇文章中,我们将首先为大家梳理 LLMOps 的核心概念,通过一个具体的智能客服系统示例来帮助大家理解 LLMOps 在实际工作中的应用场景。随后,我们将重点分析和对比市面上几款主流的开源 LLMOps 框架。通过这第一步,我们希望能为大家在这个快速发展的领域中提供一个清晰的导航图,并为后续系列中选择一款核心工具进行深度实践打下基础。

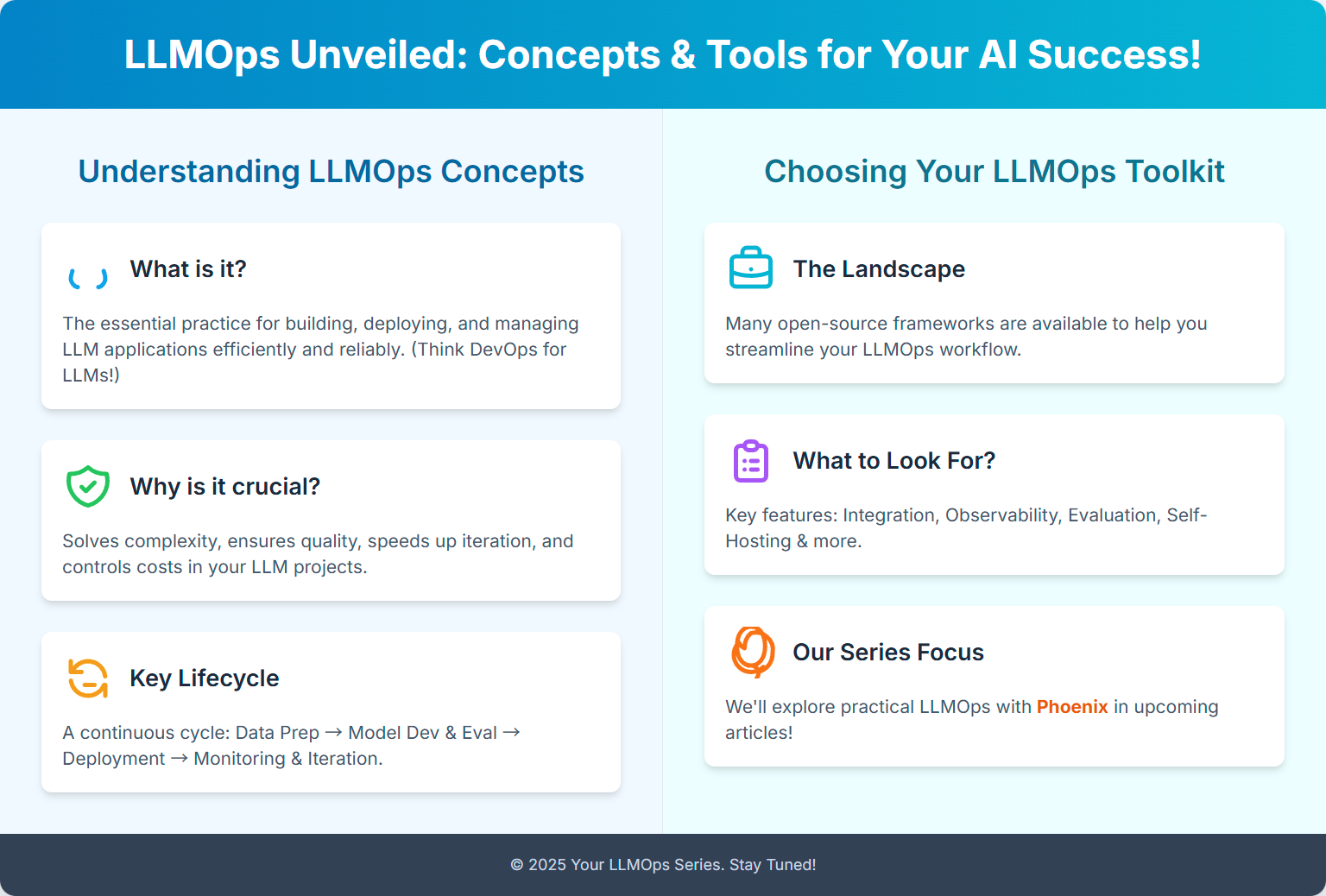

LLMOps

在传统的软件开发领域,DevOps(开发运维一体化)指的是一套旨在“通过自动化‘软件交付’和‘架构变更’流程,使软件的构建、测试与发布更为快捷、频繁和可靠”的实践与文化 [1] 。与此类似,随着 LLM 的广泛应用和快速发展,为了提升基于 LLM 应用的开发部署效率与质量,LLMOps 的概念应运而生。

那么,究竟什么是 LLMOps 呢? LLMOps(Large Language Model Operations,大型语言模型运维)可以理解为 DevOps 和 MLOps(机器学习运维)理念在大型语言模型领域的延伸与专门化。它是一整套贯穿大型语言模型(如 GPT 系列)从开发、部署、监控、维护到持续优化的完整生命周期的实践、流程与工具体系。[2] LLMOps 的核心目标在于,确保能够高效、可扩展、可靠且负责任地运用这些强大的 AI 模型来构建和运营实际应用,最终加速价值创造并降低潜在风险。

为了更直观地理解 LLMOps,我们来看一个示例。

示例

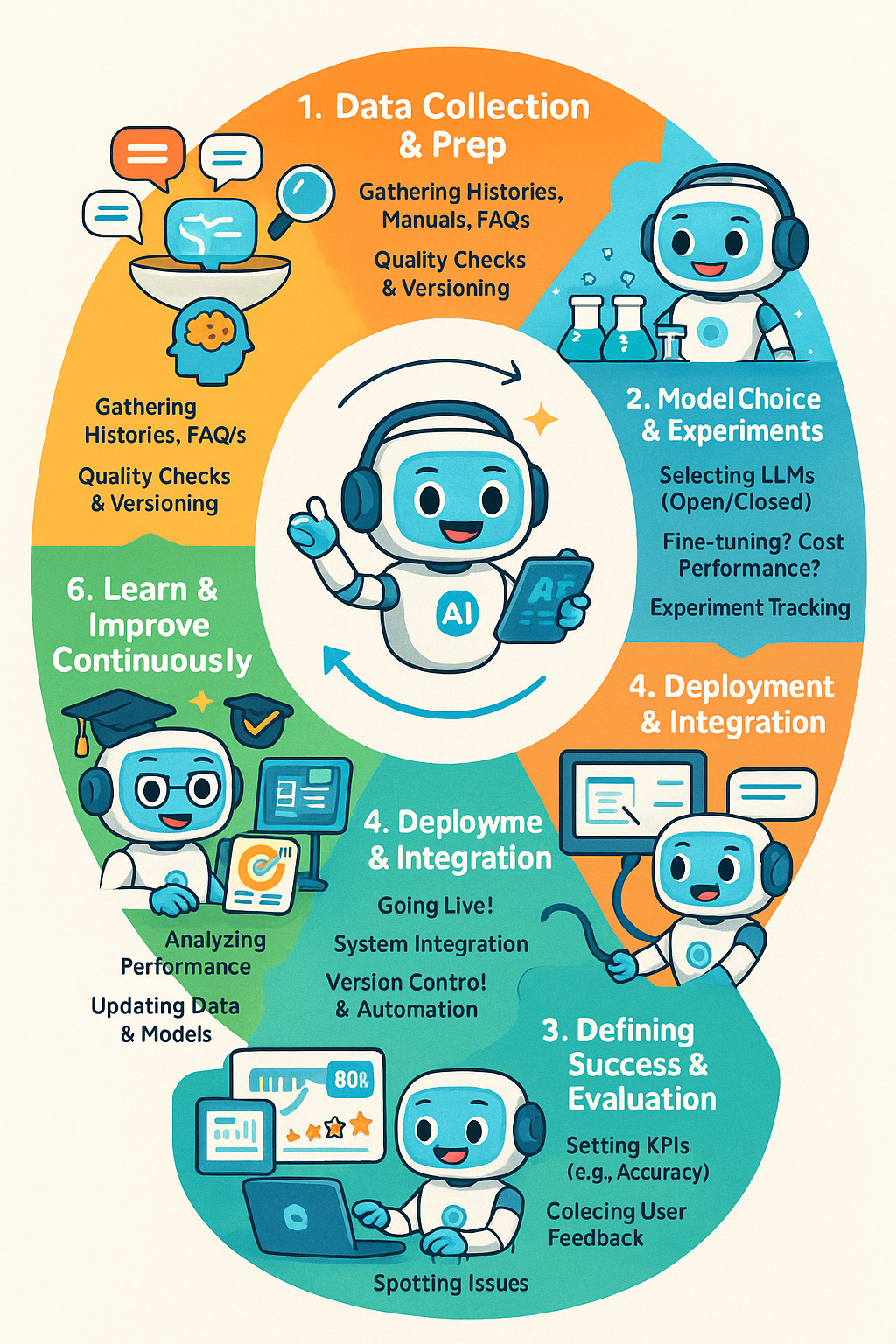

假设某公司计划开发一套基于 LLM 的智能客服系统,期望该系统能够处理以下任务:解答产品相关咨询、处理客户的退换货请求以及提供物流状态查询等。

要成功落地并持续运营这样一套系统,LLMOps 将在以下关键环节发挥作用:

-

数据准备与管理:万丈高楼平地起,数据是基石。首先,需要系统地收集和整理相关数据,例如:历史客服对话记录、产品手册与规格说明、常见问题(FAQ)文档、公司退换货政策细则等。LLMOps 需确保这些数据的质量、版本控制和可访问性,为后续的模型训练、微调和评估打下坚实基础。

-

模型选型与实验:数据就绪后,就进入了 LLM 的选型阶段。这可不是拍脑袋就能决定的,需要综合考量多个因素:“当前市面上的模型(如 GPT-4, Llama 3 等)哪个更适合我们的业务场景?”、“是选择强大的闭源商业模型,还是灵活的开源模型?”、“模型是否需要针对特定客服任务进行微调(fine-tuning)以提升专业度?”、“相关的成本(如 API 调用费、训练资源消耗)是否可控?”。LLMOps 在此阶段强调实验的可追溯性和结果的可复现性,帮助团队科学决策。

-

需求量化与评估体系构建:有了初步选型,接下来要把“好用”这个模糊概念具体化。比如,我们期望“回答产品问题的准确率达到 80%以上”。那么,如何定义和评估这个“准确率”?是由人工抽检,还是设计一套自动评估流程(甚至可能用另一个 LLM 来辅助评估)?LLMOps 要求建立明确的评估标准、准备高质量的评估数据集,并通过模型微调、提示词工程(Prompt Engineering)等技术手段持续优化 LLM 的输出,确保其性能达标。

-

部署与集成:当模型在测试环境中表现优异,达到上线标准后,就需要将其稳妥地部署到生产环境,并与公司现有的客服系统、订单管理系统等业务流程无缝集成。LLMOps 关注部署的自动化、版本控制以及不同环境(开发、测试、生产)的一致性

-

持续监控与反馈:模型上线绝不意味着万事大吉,恰恰相反,真正的考验才刚刚开始。持续监控至关重要,这包括:主动收集用户对智能客服回答的满意度反馈、实时追踪 LLM 的关键性能指标(如响应延迟、吞吐量、错误率)、密切关注运营成本(如 API 调用量)和计算资源使用情况等。

-

迭代优化:根据监控到的实际运行数据、用户反馈以及业务需求的变化,团队需要对智能客服系统进行周期性的迭代优化。这可能涉及到数据更新与扩充、模型再微调、提示词库的调整,甚至是模型架构的升级。LLMOps 强调形成一个闭环的迭代流程,让模型和应用能够持续进化。

以上描述的从数据准备到模型选型、训练、评估、部署、监控和持续优化的完整生命周期管理,都属于 LLMOps 的范畴。

从上述智能客服系统的示例中可以看出,一个完整的 LLM 应用落地涉及诸多环节,其复杂性和精细化运营的需求不言而喻。如果完全依靠手动管理整个生命周期,不仅效率低下、容易出错,而且难以保证过程的一致性和结果的可追溯性。为了应对这些挑战,简化开发流程,并提升 LLM 应用的整体质量与运维效率,业界涌现了许多专门的 LLMOps 工具和框架。这些框架旨在为开发者提供从实验追踪、数据管理、模型评估到生产监控等一系列“趁手兵器”,从而系统性地支持 LLM 应用的开发与运维。接下来,我们将一同探讨目前市面上一些主流的开源 LLMOps 框架及其特性。

开源框架

目前市面上已涌现出众多优秀的开源 LLMOps 框架,旨在帮助开发者提高 LLM 应用的开发与迭代效率。您可以参考 tensorchord/Awesome-LLMOps,这个 GitHub 仓库,它整理了一份详尽的 LLMOps 工具列表。

然而,值得注意的是,该仓库中列出的一些框架与特定的开发流程或库深度绑定。这意味着,若要利用这类框架进行 Prompt 管理、LLM 调用追踪等操作,开发者可能必须采用该框架自身的开发范式,而无法灵活选用 openai、langgraph 或 llamaindex 等主流 LLM 开发库。

对于期望更高灵活性的开发者而言,这种限制可能并不理想。因此,在筛选框架时,我们设定了以下几个核心要求:

- 广泛的集成性:应能良好支持并集成业界常见的 LLM 开发包,如

openai、langgraph、llamaindex等。 - 便捷的可观测性:能够方便地对 LLM 的请求、响应及中间过程进行追踪和可视化。

- 支持自托管 (Self-hosting):允许在私有环境中部署和运行,以确保数据安全和自主可控。

经过筛选,以下几个开源框架基本满足上述要求:

接下来将对这些框架进行逐一介绍和效果展示。

基本介绍和效果展示

langfuse

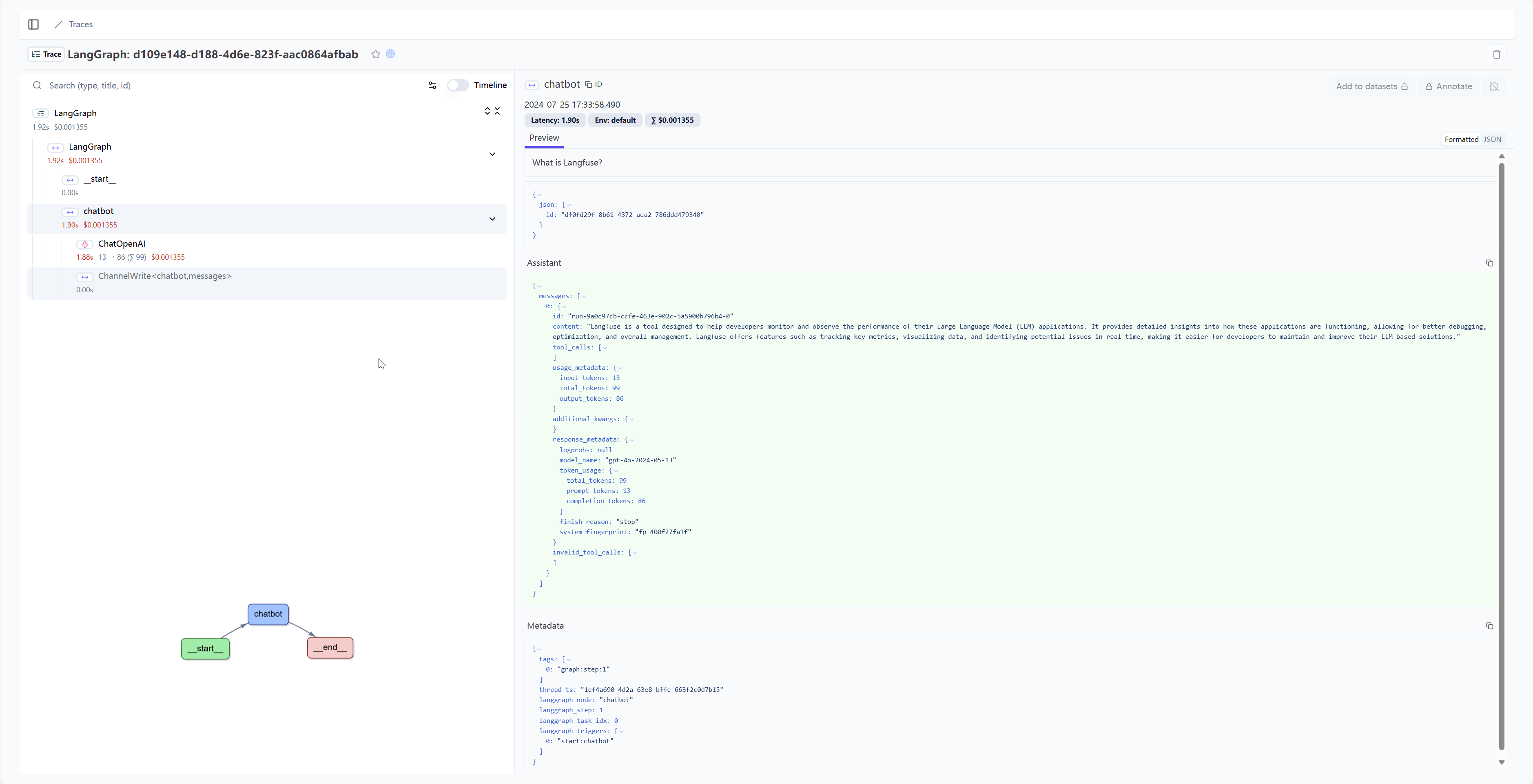

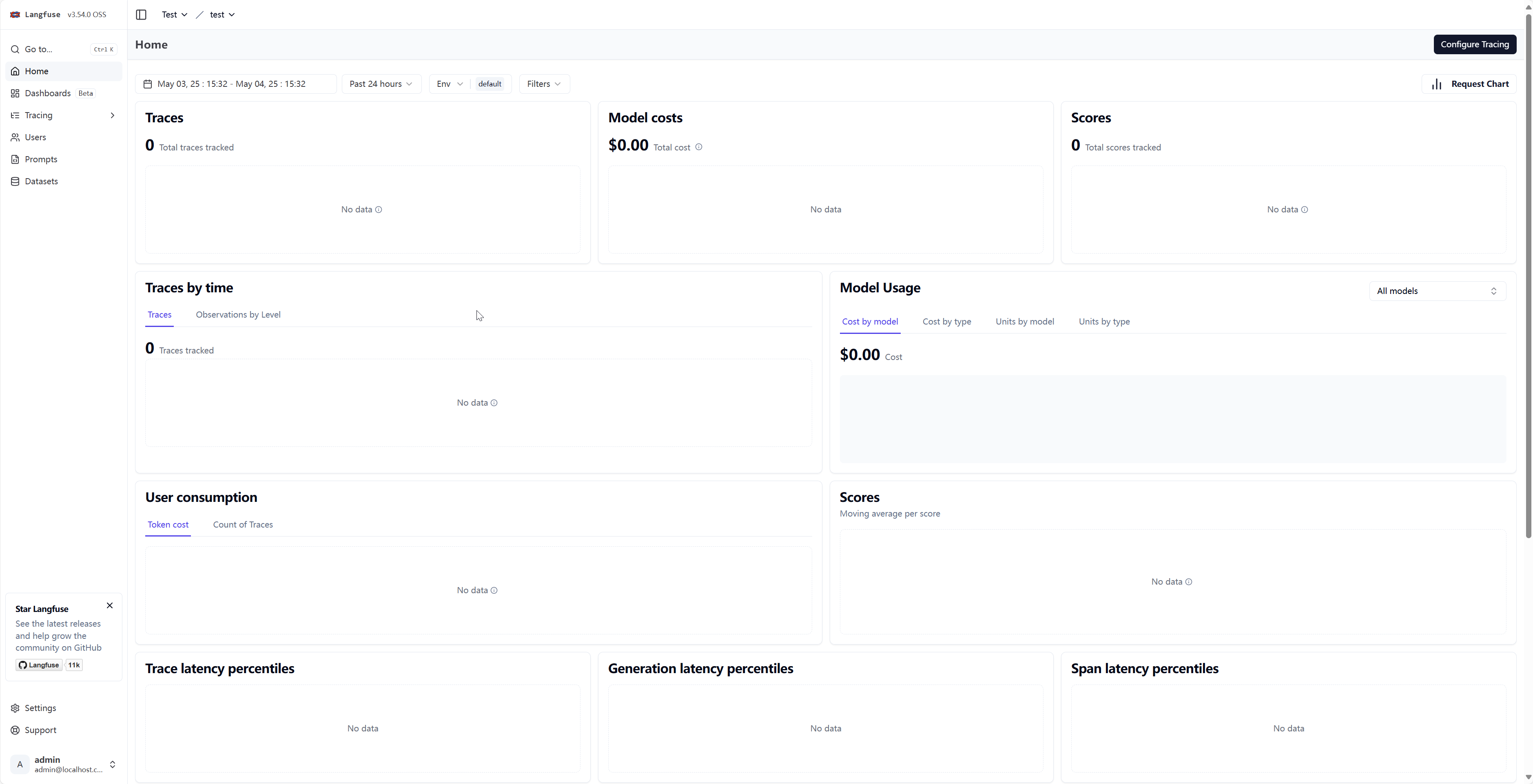

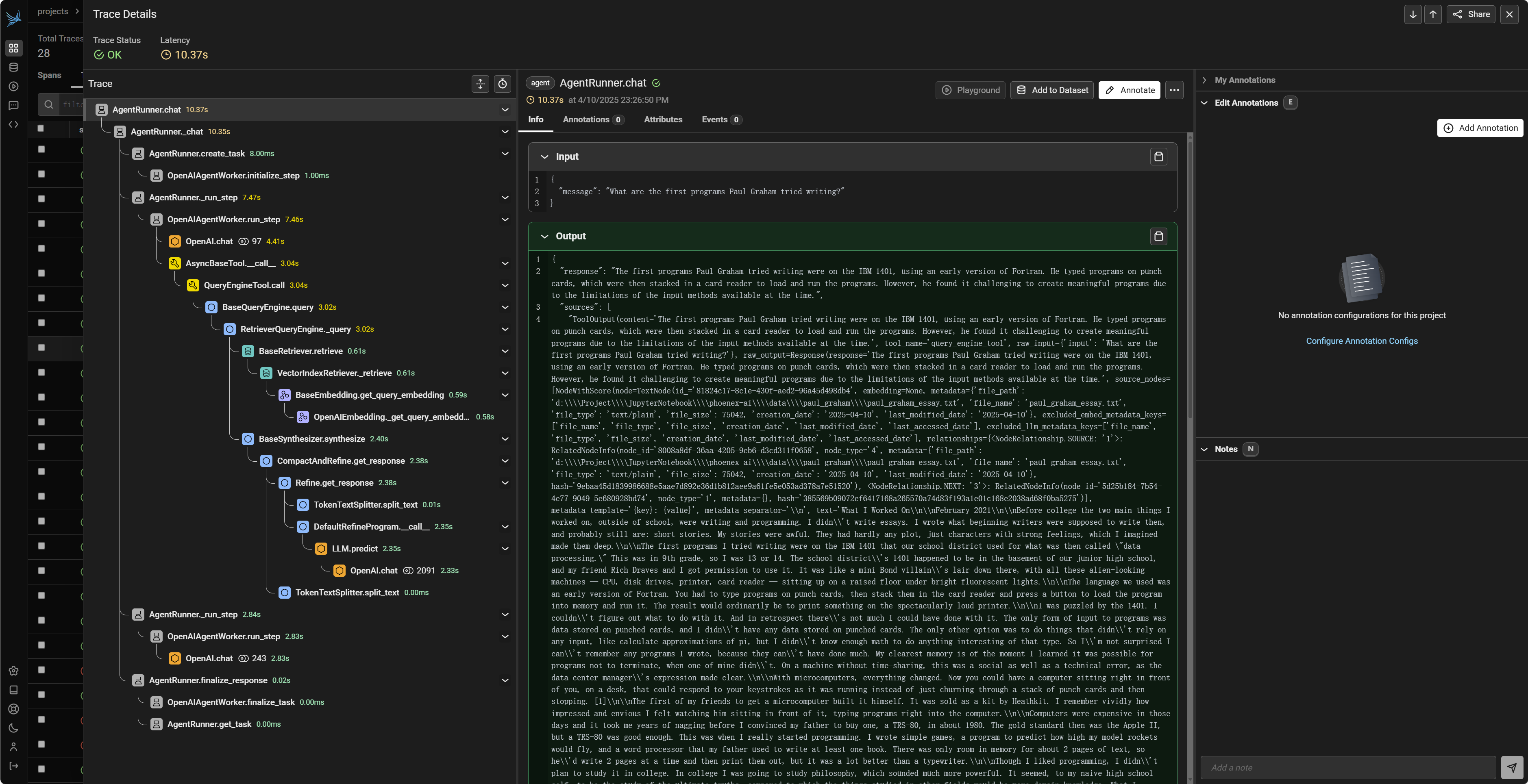

langfuse[3] 是目前社区中热度较高的 LLMOps 框架之一,其 GitHub Star 数量已超过 1.1 万。自两年前发布 v1.0.0 版本以来,项目持续迭代,最近已更新至 v3.54.0,展现了良好的维护和发展势头。此外,Langfuse 的一个显著优点是其广泛的集成能力,能够与 OpenwebUI、Dify、Ragflow、Langflow、LobeChat 等多种流行工具和框架无缝集成[4]

其 LLM 调用链路的可视化追踪功能表现出色,同时仪表盘提供的统计项也相当丰富,近期还新增了自定义仪表盘功能。

略有遗憾的是,官方文档中展示的部分高级功能,如 Prompt Experiments 和 LLM Playground,仅在自托管的 Pro 版本中提供。但对于仅需追踪 LLM 应用使用情况的用户而言,其基础版本已能满足核心需求。

helicone

Helicone[5] 常在讨论中与 Langfuse 对比[6]。 但观察其 GitHub 项目主页可以发现,该项目自 2024 年 8 月发布 v0.0.1 版本后,虽然代码库仍在更新,但并未发布新的正式版本。

在尝试本地部署时,根据官方文档指引遇到了一些问题。通过调整 flyway.conf 和 dockerfile_migrations 文件,并额外配置本地 Supabase 后,migrations 与 jawn 服务得以启动,但登录页面一度无法正常工作。后续尝试使用 docker-compose-legacy.yml 文件进行部署则取得了成功。

部署成功后发现,其免费版本在功能上有所限制,例如评估(Evaluation)功能最多只支持三项。

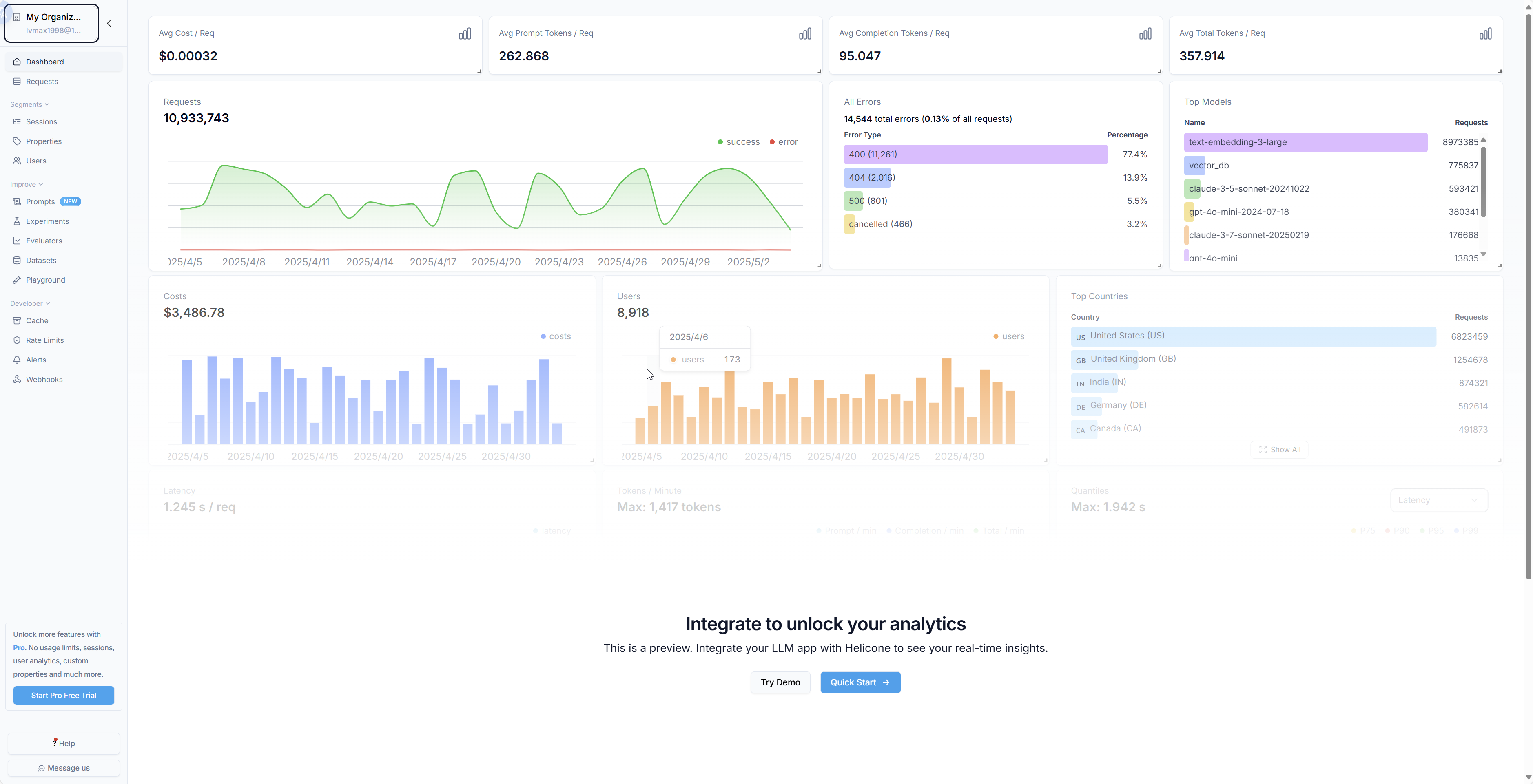

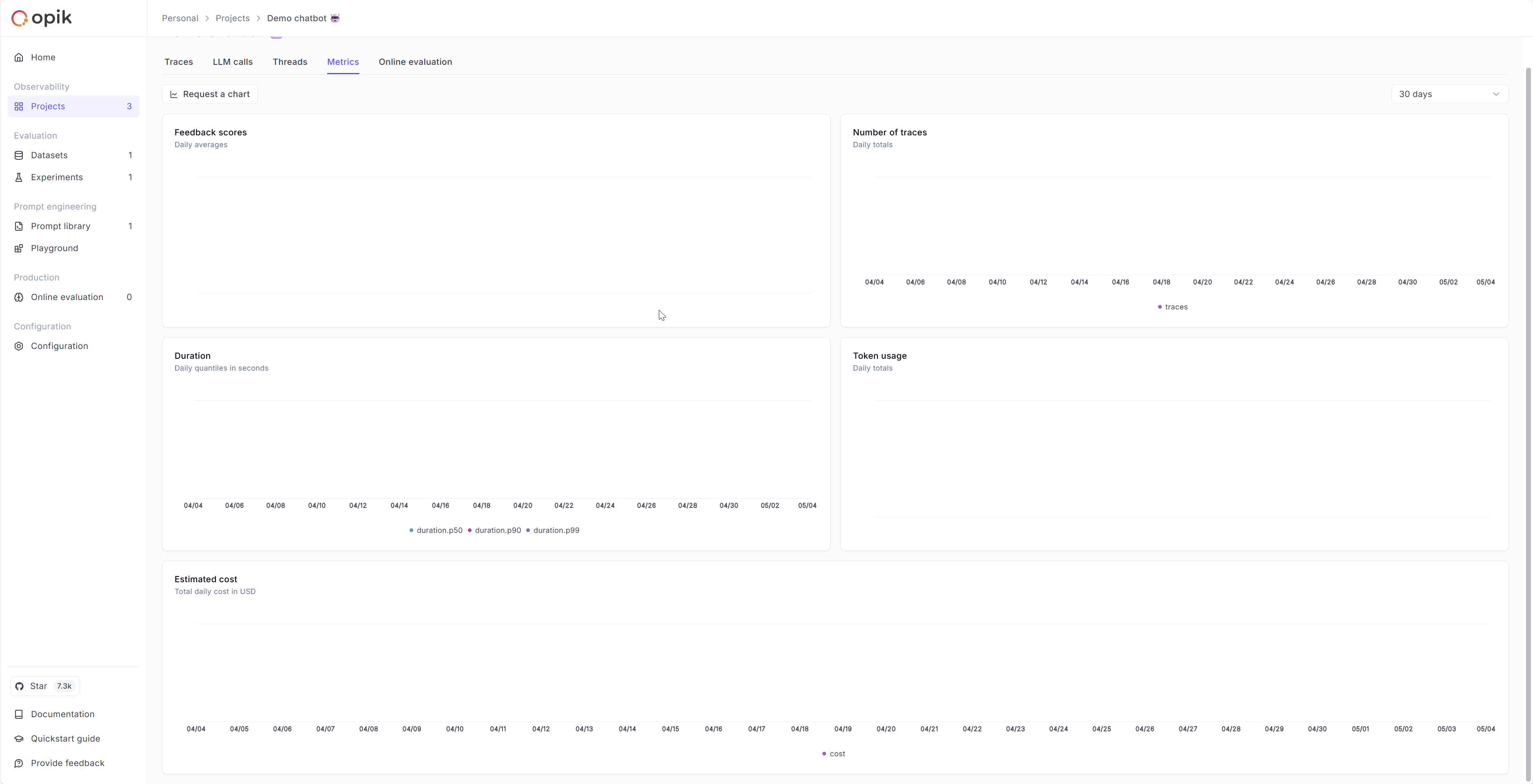

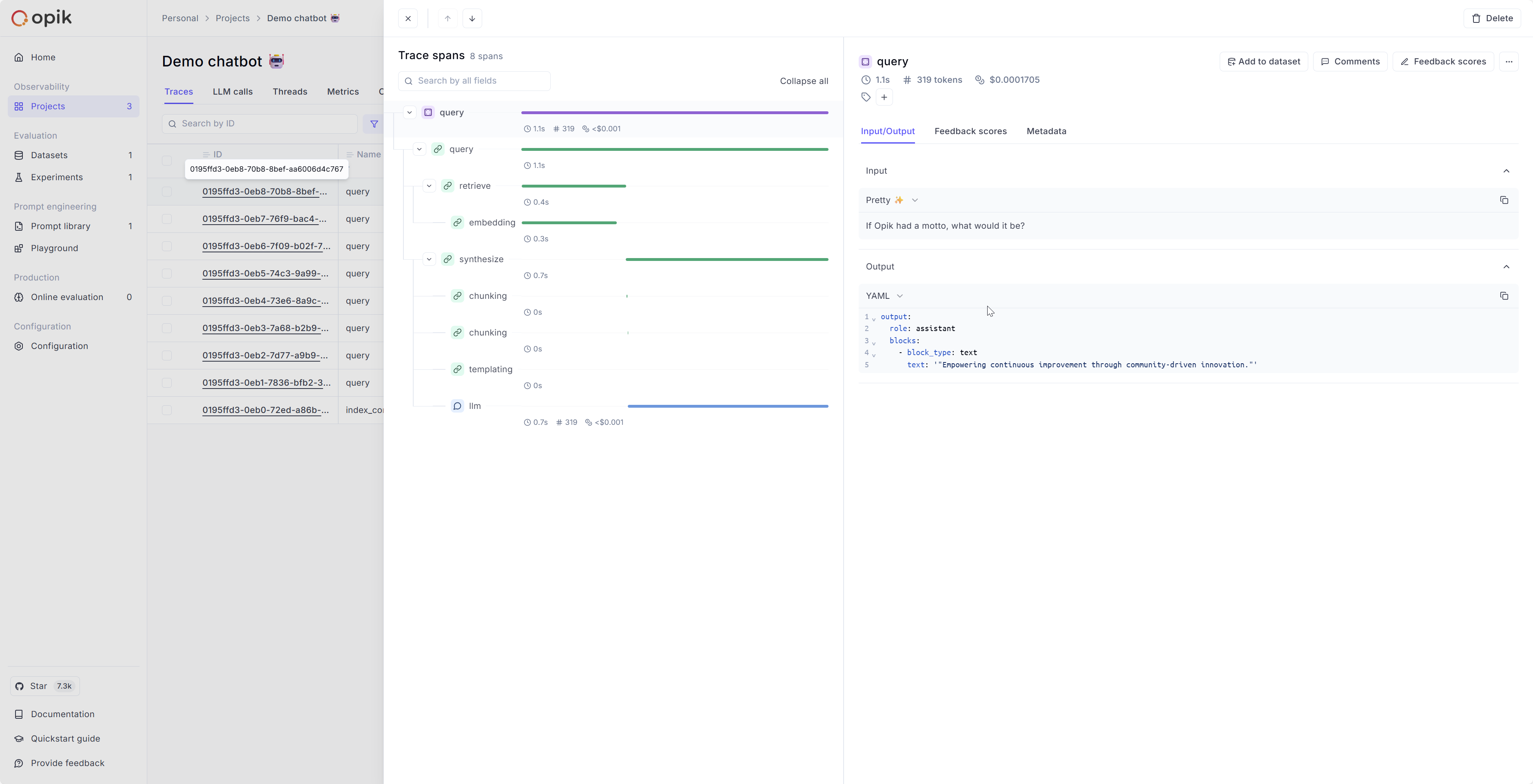

opik

opik[7] 是除了 langfuse 之外,dify 集成的另一个开源 LLMOps 框架。它的 UI 给人的第一印象是简洁美观,自托管版本的功能较为全面,甚至包含了一些在 Langfuse Pro 版本中才提供的功能,如 Experiments 和 Playground。

Opik 的一个显著特点是支持在线评估(Online Evaluation)功能。这意味着系统在生产环境运行后,仍能通过自定义规则自动对 LLM 的输出进行评分。这有助于开发者了解模型在真实场景下的表现与在评估数据集上的表现差异,为后续优化提供依据。

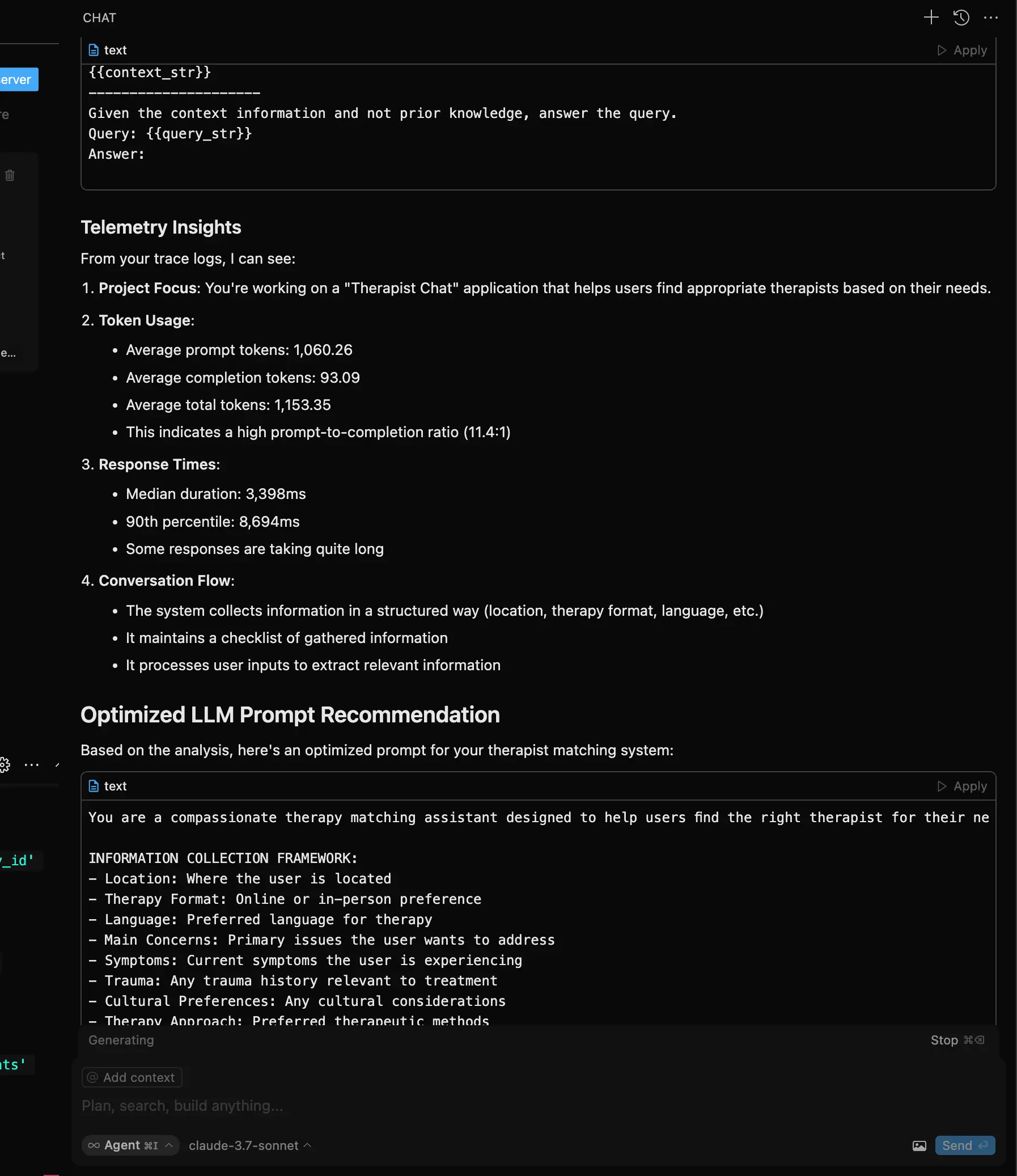

此外,Opik 还引入了 MCP(Meta Controller Proxy)服务器[8]。开发者可以通过 Cursor 等工具连接 MCP 服务器,获取详细的追踪信息,进而指导 Agent 的开发与优化。

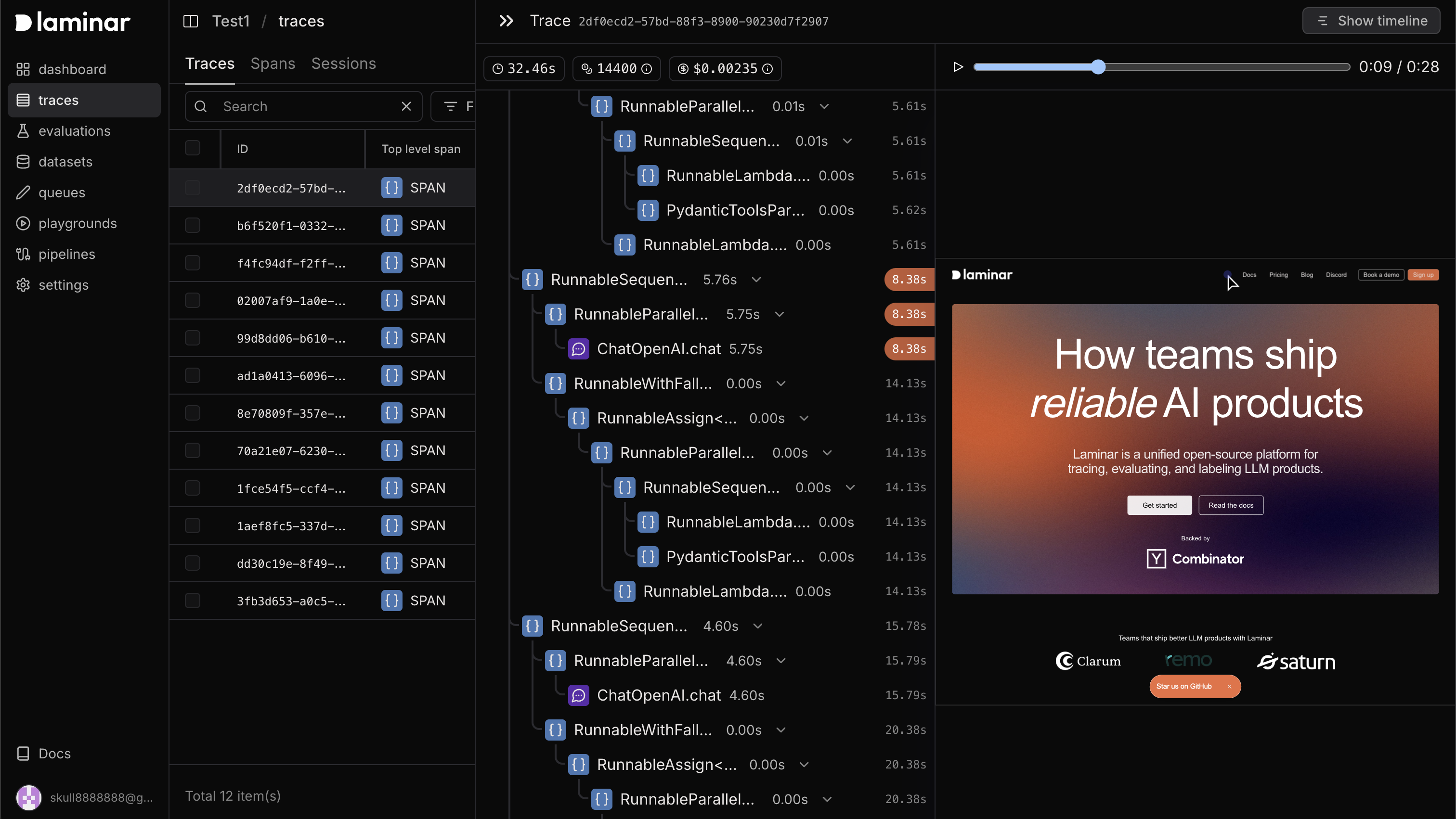

lmnr

lmnr[9] 同样是一款功能较为完备的 LLMOps 框架。与其他框架相比,它更侧重于对浏览器自动化场景的强化支持。针对于前段时间 manus 带火的 Browser Use 等浏览器自动化库这类场景进行了特殊优化,能够便捷地追踪 LLM 在浏览器操作过程中的决策链路,从而利于后续的调试与迭代。

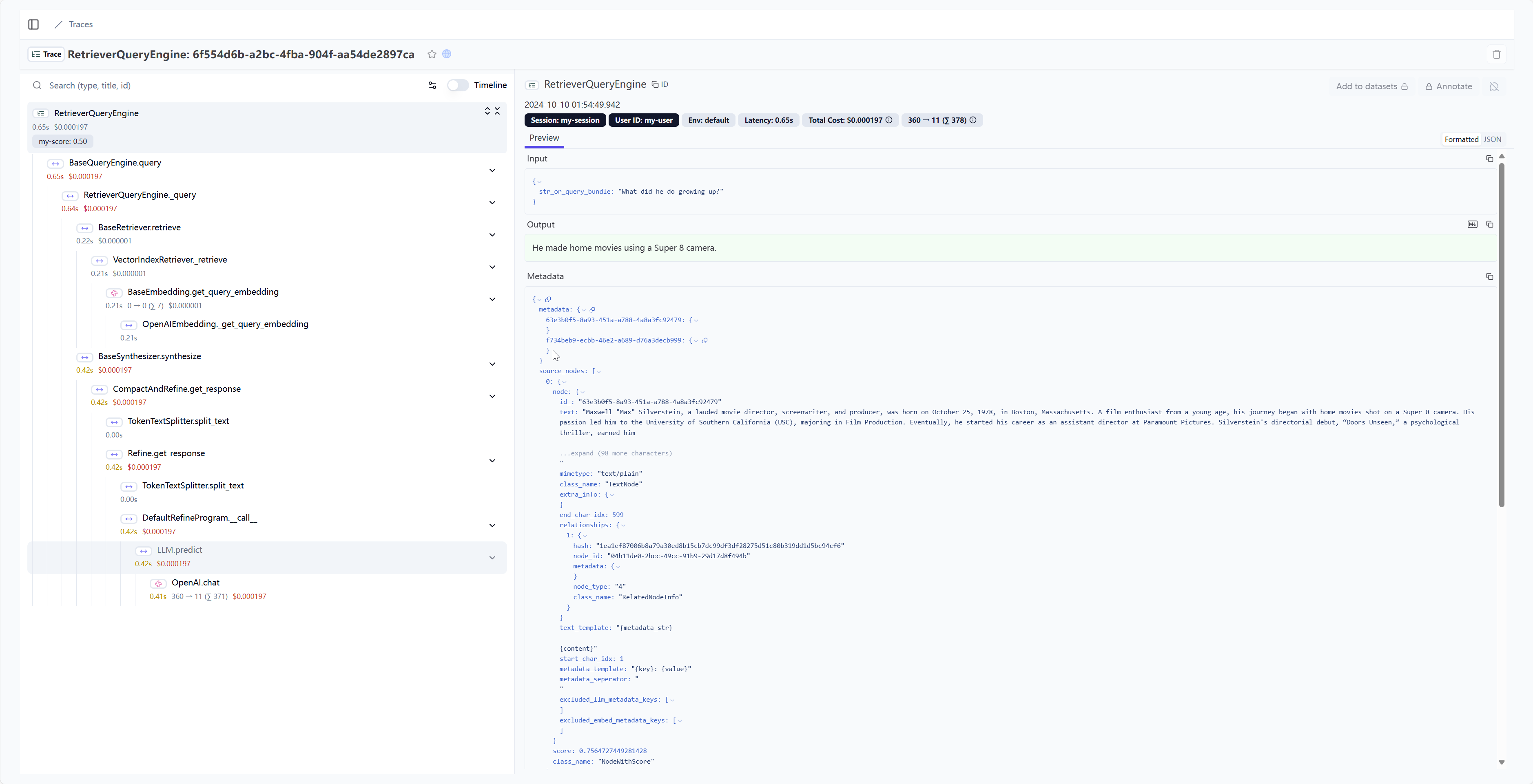

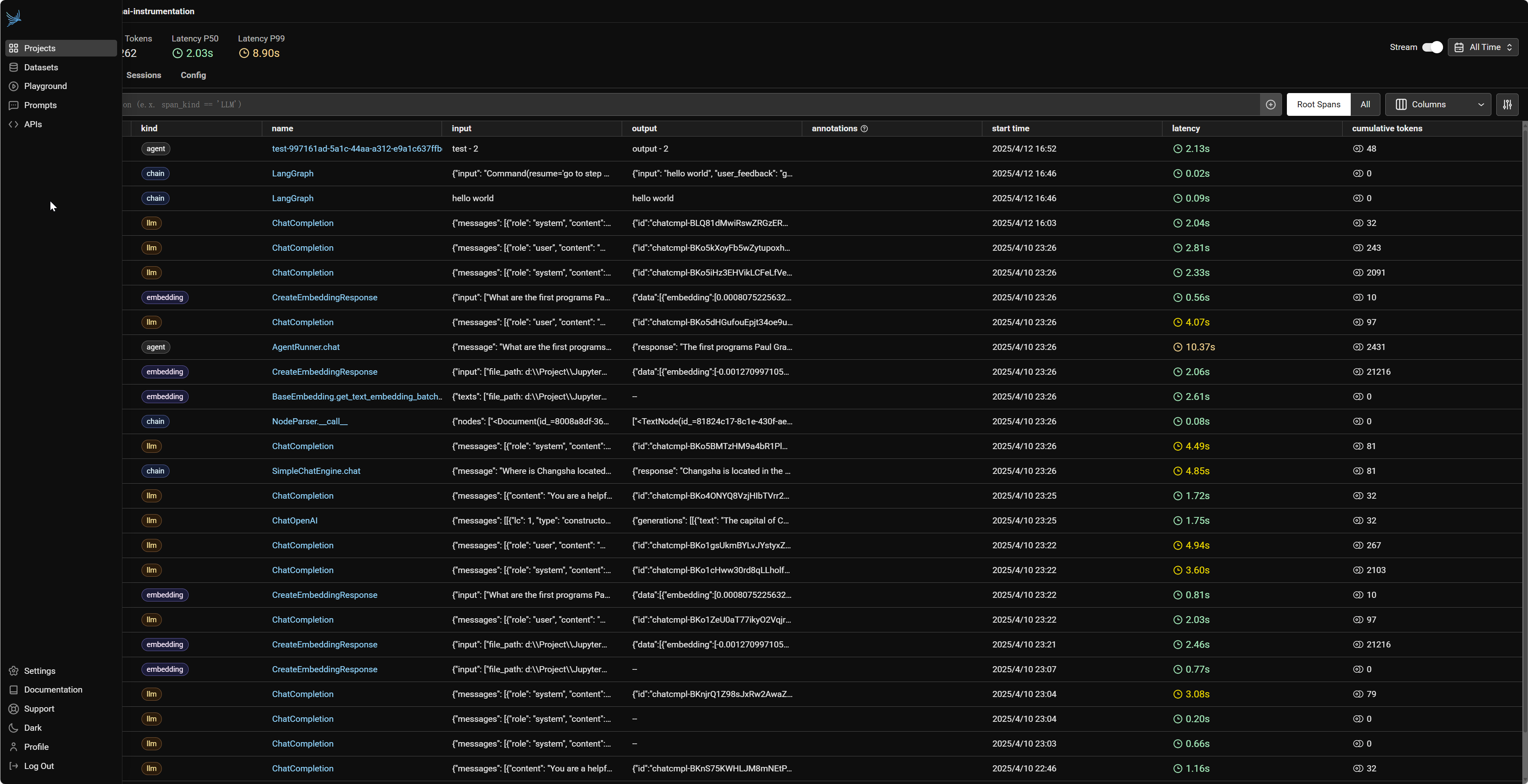

phoenix

pheonix[10] 的用户界面可能不如前述某些框架精致,但其功能覆盖面广泛,可谓“五脏俱全”。它不仅具备 Playground、Evaluation 和 Experiment 等核心功能,还集成了 Ragas 等评估库,并支持对 Qdrant、Milvus 等向量数据库进行可视化。

与 Opik 类似,Phoenix 也提供了 MCP Server,便于通过 Claude Desktop、Cursor 等客户端进行交互和操作。[11]

美中不足的是,Phoenix 目前不提供图表化的统计仪表盘,仅展示按时间筛选的 Trace、Token 和 Latency 等基本指标,在数据统计丰富度上可能不及 Langfuse。但是,其他提供丰富图表统计的框架(如 Langfuse、Opik)依赖 ClickHouse 等组件,而 Phoenix 由于不包含此类重度依赖,其资源占用相对较低,是所有对比框架中最轻量级的。

选择建议

经过对上述几款主流开源 LLMOps 框架的初步了解和对比,相信大家对它们各自的特点和适用场景有了一定的认识。选择建议如下:

- 如果你追求与 LangChain 生态的紧密集成,并且不介意商业方案,可以关注 LangSmith(尽管本文未详细介绍,但它是 LangChain 官方推出的 LLMOps 平台,值得了解)。

- 如果你的核心需求是详尽地记录和追踪 LLM 的调用情况,并且看重社区活跃度和广泛的集成性,Langfuse 是一个非常成熟和功能丰富的选择。

- 如果你需要更全面的 LLM 应用监控、评估和优化能力,那么:

- 若你的应用场景涉及浏览器自动化 Agent 的开发,LMNR 提供了针对性的强化支持。

- 若你特别强调在生产环境中进行在线评估(Online Evaluation)的能力,Opik 具备独特的优势。

- 若部署环境的资源占用是你首要考虑的因素之一,并且对复杂的统计图表需求不高,那么相对轻量级的 Phoenix 可能更适合你。

当然,框架的选择没有绝对的“最优”,关键在于是否契合你的具体需求、团队技术栈以及项目目标。

总结与展望

在本篇文章中,我们一同探讨了 LLMOps 的核心理念,理解了它对于高效、可靠地开发和运维大型语言模型应用的关键作用。通过一个智能客服系统的实践案例,我们具体感知了 LLMOps 在项目全生命周期中的各个环节。此外,我们还对市面上几款主流的开源 LLMOps 框架进行了初步的了解和对比,分析了它们在集成性、可观测性以及自托管支持等方面的特点。

基于这些前期的探讨和对比,为了在本系列后续文章中能更深入地带领大家体验 LLMOps 的实际操作,选择一款合适的工具至关重要。综合考量了各框架的易用性、轻量级特性、对核心追踪与数据记录功能的支持,以及对初学者快速上手的友好度,我们决定选用 Phoenix 框架。我们相信,Phoenix 能够帮助我们在学习过程中,更加专注于 LLMOps 的核心实践——即如何通过有效的追踪分析来驱动优化——而无需在初期就过多投入到复杂环境的配置中。

展望未来,本系列将以 Phoenix 为核心工具,带领大家进一步深入 LLMOps 的实践领域。目前的初步规划如下:

-

第二篇:Phoenix 基础入门。 在下一篇文章中,我们将手把手带您完成 Phoenix 的安装与基本配置,演示如何将其集成到您的第一个简单 LLM 应用中,并一起探索如何利用 Phoenix 来追踪请求、分析模型输出,为后续的“优化”之旅打下坚实的追踪与分析基础。

-

后续篇章:聚焦核心优化场景。 在掌握了 Phoenix 的基本使用之后,我们将逐步深入,探讨如何利用 Phoenix 的追踪分析能力来辅助我们进行:

-

提示词工程的迭代与优化。

-

Agent 中工具调用的分析与改进。

-

RAG(检索增强生成)系统的全链路诊断与性能提升。

-

我们希望通过这一系列由浅入深、理论与实践相结合的文章,能让大家对 LLMOps 的理解从概念层面真正走向动手操作,并最终能够运用所学知识提升自己 LLM 应用的质量和效率。

langfuse/langfuse: 🪢 Open source LLM engineering platform: LLM Observability, metrics, evals, prompt management, playground, datasets. Integrates with OpenTelemetry, Langchain, OpenAI SDK, LiteLLM, and more. 🍊YC W23 ↩︎

Helicone/helicone: 🧊 Open source LLM observability platform. One line of code to monitor, evaluate, and experiment. YC W23 🍓 ↩︎

The best LLMOps Platform? Helicone Alternatives - Langfuse ↩︎

comet-ml/opik: Debug, evaluate, and monitor your LLM applications, RAG systems, and agentic workflows with comprehensive tracing, automated evaluations, and production-ready dashboards. ↩︎

lmnr-ai/lmnr: Laminar - open-source all-in-one platform for engineering AI products. Create data flywheel for your AI app. Traces, Evals, Datasets, Labels. YC S24. ↩︎